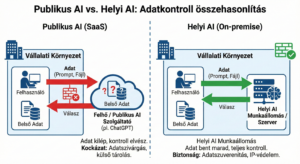

A generatív mesterséges intelligencia ma már nem csupán egy izgalmas „techjáték”: a modern vállalatvezetésben a döntéstámogatás, a szerződéselemzés és a kockázatkezelés alapvető motorjává vált. A probléma azonban kritikus: a legtöbb szervezet úgy használja a publikus AI-szolgáltatásokat, mintha azok belső, védett vállalati alkalmazások lennének.

A publikus AI alaplogikája a többszereplős felhő (SaaS): az adatok külső infrastruktúrán futnak, a bevitt tartalom feletti kontroll pedig kicsúszik a kezünkből. A tanulságot nemrég az amerikai kibervédelmi ügynökség (CISA) esete demonstrálta: egy vezető „csak hivatalos használatra” (FOUO) jelölésű dokumentumokat töltött fel a ChatGPT nyilvános verziójába, ami azonnali biztonsági riasztást váltott ki. Ha egy ilyen, kiberbiztonságra szakosodott óriásnál ez megtörténhet, egy hazai KKV esetében nem az a kérdés, hogy „előfordulhat-e” a szivárgás, hanem az, hogy mikor.

Az illúzió vége: Mi történik az adatainkkal a „felhőben”?

A publikus AI-szolgáltatások használatakor az adat elhagyja a szervezet biztonságos környezetét. Ebben a pillanatban megszűnik a közvetlen kontroll:

- Nincs beleszólásunk a megőrzési időbe: Nem mi szabjuk meg a törlési garanciákat vagy a jogi visszatartás (legal hold) szabályait.

- Auditálhatatlan láncolat: Nem látunk rá a szolgáltató teljes alvállalkozói és infrastruktúra-láncára.

- Emberi tényező: A biztonság egyedül a felhasználói fegyelmen múlik – azon, hogy a kolléga beilleszt-e üzleti titkot, HR-anyagot vagy ügyféladatot a promptba.

A CISA-ügy rávilágított: a feltöltött adatok a szolgáltatónál maradhatnak, és fennáll a veszélye, hogy azok (akár indirekt módon) beépülnek a modell későbbi válaszaiba.

Kockázati térkép: A láthatatlan adatszivárgás csatornái

A „Copy-Paste” csapdája

A legtöbb incidens nem külső hackertámadás, hanem egyszerű mulasztás eredménye. A Samsung híres esete, ahol a fejlesztők bizalmas forráskódot másoltak a ChatGPT-be, jól mutatja, milyen könnyen válik a kényelem a szellemi tulajdon ellenségévé.

A törlés nem jelent megsemmisítést

Még ha a szolgáltató felülete szerint töröltük is az adatot, jogi eljárások vagy bírósági rendelkezések kötelezhetik a tech-óriásokat az adatok megőrzésére. Ez azt jelenti, hogy a vállalatunk „digitális lábnyoma” tőlünk független jogi folyamatok részévé válhat.

Szabályozói szigor

Az európai felügyeletek – élükön az olasz adatvédelmi hatósággal (Garante) – már 2023-ban korlátozásokat vezettek be a ChatGPT-vel szemben. A szabályozói környezet egyértelműen a szigorúbb adatkezelés irányába mutat.

Miért nem elég a tiltás? A „Shadow IT” felemelkedése

A vezetők gyakran abba a hibába esnek, hogy egyszerűen megtiltják az AI használatát. Ez azonban nem megoldás, csupán remény. Az AI úgy terjed a szervezetben, mint a „Shadow IT”: gyors, kényelmes, és üzleti nyomás alatt a kolléga a „megoldást” fogja választani a „szabály” helyett. Ha nincs engedélyezett, biztonságos belső alternatíva, a munkatársak vissza fognak térni a publikus eszközökhöz.

Megfelelés és a helyi AI megoldása

A fenntartható vállalati működés ma már elválaszthatatlan a digitális etikától és a jogi megfeleléstől:

- GDPR: Elvárja a kockázatarányos technikai védelmet (titkosítás, hozzáférés-kezelés).

- NIS2: A kiberkockázat-kezelést a teljes ellátási láncra kiterjeszti.

- EU AI Act: Kötelezővé teszi az „AI-műveltséget” (AI literacy) és a szabályozott, oktatott használatot.

A publikus AI-ba másolt érzékeny adat tehát nemcsak üzleti, hanem súlyos compliance-kockázat is.

A megoldás: Helyben telepített AI munkaállomás

A „helyi AI” (on-prem / edge) lényege, hogy a modell futtatása és a tudásbázis kezelése a szervezet saját infrastruktúráján történik.

Ez a valódi adatszuverenitás: „Én látom, nálam van, én döntöm el, meddig marad ott.”

A helyi AI gyakorlati előnyei:

- Valódi adatszuverenitás: „Én látom, nálam van, én döntöm el, meddig marad ott”.

- IP-védelem: A stratégiai anyagok soha nem hagyják el a házat.

- RAG technológia: A modell a saját dokumentumtárunkra építve, a belső szakzsargonunkat használva válaszol.

- Auditálhatóság: Minden adatmozgás visszakövethető.

Szakértői keretrendszer – A biztonságos AI bevezetése

Az innoGold Pro Kft. ügyvezető tulajdonosa, Vonnák Péter, mérnök informatikus, mérnök közgazdász, digitális marketing szakközgazdász Magyarország egyik legismertebb üzleti Ai szakértője szerint a helyi AI nem csupán egy „kütyü”, hanem kritikus üzleti kontrollmechanizmus. Azoknak a szektoroknak javasolja, ahol az adat maga a versenyelőny: pénzügyi szolgáltatók, egészségügy, jogi tanácsadók és K+F cégek.

A biztonságos átállás menetrendje:

- Adatklasszifikáció: Mi mehet publikusba és mi szigorúan belső?

- AI-csatorna kijelölése: Saját infrastruktúra vagy dedikált vállalati felhő.

- Szabályzat és oktatás: Világos határok és folyamatos képzés.

- Pilot projekt: Egy kritikus folyamat (pl. szerződés-összegzés) automatizálása.

Miért most? A hardver az új szűk keresztmetszet

A helyi AI kiépítése beruházás, amelynél az időtényező kritikusabb, mint gondolnánk. A globális ellátási láncok feszítettsége nem elmélet:

- Nyersanyaghiány: Az IEA előrejelzései szerint a réz és az ezüst piacán strukturális hiány várható, ami közvetlenül drágítja a hardvergyártást.

- Technológiai torlódás: A csúcskategóriás AI-chipek és a speciális memóriák (HBM) kapacitásai 2026-ra és 2027-re is előre lefoglaltak.

Üzleti fordítás: Aki későn lép, nemcsak magasabb árakkal, hanem drasztikusan megnövekedett szállítási időkkel is szembesülhet – miközben a versenytársak már a saját, védett AI-rendszerükkel gyorsítják a folyamataikat.

„A versenyelőny a következő 12–24 hónapban ott keletkezik, ahol érzékeny adatokkal is lehet AI-t használni. Ez kulcsszerepet játszik akkor, ha belső szenzitív adataink alapján szeretnénk a folyamatokat gyorsítani.”

fogalmazott Vonnák Péter.

Konklúzió

A kérdés már nem az, hogy használunk-e AI-t, hanem az, hogy ki birtokolja az adatot. A versenyelőny alapja a biztonságos, saját tudásbázisra épített intelligencia lesz.